최근 반도체 시장의 화두는 단연 메모리입니다. “GPU가 왕이다”라는 인식은 이제 옛말이 되어가고 있습니다. 카이스트 김정호 교수님의 유튜브 인터뷰를 통해 메모리, 특히 HBF(플래시 기반 적층 메모리)가 AI 시대 어떻게 핵심 역할을 맡게 되는지, 그리고 이 바람에 삼성전자, SK하이닉스, 샌디스크 같은 기업이 어떻게 주목받는지 조명해 드립니다.

왜 메모리가 갑자기 주목받는가?

AI의 추론 속도와 처리량, 즉 우리에게 똑똑한 답변을 빠르게 제공하는 능력을 결정하는 핵심이 GPU의 연산력만이 아니라는 점이 최근 강조되고 있습니다. 실제로 AI가 생성해내는 단어의 속도부터 대용량 모델의 성능까지 ‘메모리 대역폭과 용량’에 좌우된다는 논리가 증명되고 있죠.

특히 HBM(High Bandwidth Memory)은 빠른 성능으로 이미 데이터센터에서 필수로 자리 잡았지만, 최근 AI 모델의 파라미터(모델 크기)가 기하급수적으로 커지면서 용량의 한계에 직면하고 있습니다. 이에 대한 차세대 해결책으로 떠오른 것이 바로 HBF(Hierarchical Flash Memory)입니다.

HBF의 개념과 구조

HBF란 쉽게 말해 ‘대용량 플래시 메모리 적층’을 뜻합니다. GPU 바로 옆에 낸드 플래시 기반 메모리를 붙여서 수십~수백 테라바이트(100TB 이상도 가능!)의 ‘지식(프라이어)’를 고속으로 공급하는 구조를 만듭니다.

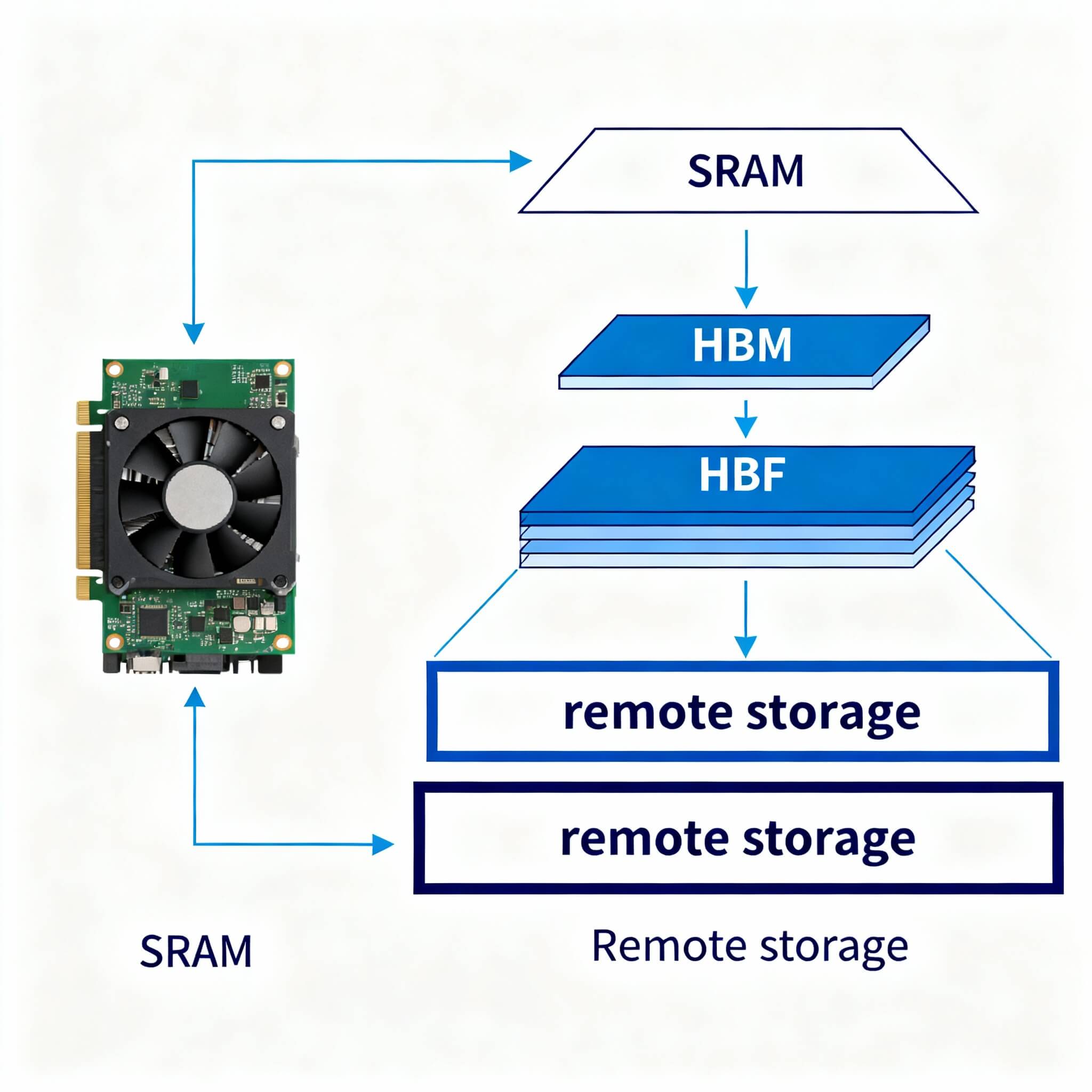

계층형 메모리 아키텍처

- SRAM (HBM 패키지 내부, 초고속/소용량)

- HBM (고속/중용량)

- HBF (중간속도/초대용량)

- 원격 스토리지 (저속/저비용)

즉, SSD나 기존 스토리지보다 훨씬 GPU 연산에 가까운 위치에 플래시 적층 메모리를 배치해 페타바이트급 모델도 GPU가 실시간으로 참조할 수 있게 해준다. 메모리 공급의 병목을 해결하는 동시에, AI의 ‘실시간 지식확장’이 가능해지는 셈입니다.

산업 지형도, 삼성·SK·샌디스크의 기회

여기서 주목할 점은, HBF 시대가 오면 “낸드 플래시” 기술을 잘하는 회사가 대세가 된다는 것! 현재 글로벌 낸드 시장은 삼성전자와 SK하이닉스가 60% 이상 점유하고 있고, 샌디스크 등이 이를 추격 중입니다. HBM 쌓아본 경험이 있는 업체가 초기 구현에서는 더욱 앞서나갈 수 있습니다.

실제로 최근 3개월간 샌디스크의 주가가 3배나 급등한 이유도 데이터센터의 낸드 수요가 본격적으로 폭증한다는 기대 때문입니다. 김정호 교수님도 “아파트처럼 GPU 옆에 책장을 쌓듯이, HBF를 쌓는 구조가 곧 일상이 된다”고 전망합니다.

AI 기술 내부, 왜 HBF인가?

현대 AI(특히 생성형 AI)의 내부를 관찰해 보면, 인코더와 디코더 구조 전체가 암호화된 ‘지식 사전(프라이어)’를 빠르게 읽으며 결과를 생성합니다. 이 지식 사전은 텍스트뿐 아니라 이미지, 영상, 멀티모달 등의 방대한 데이터로, 용량이 점점 커져 갑니다.

- 매 단어 생성 때마다 암호책(KV캐시)을 참조

- 프라이어가 클수록 더 다양한 답변, 더 똑똑한 AI 가능

- 기존 DRAM(디램)은 용량/전력 한계로 부족, 플래시는 적층이 쉬운 강점

결국 AI가 동영상이나 이미지 생성에 진출하면 하루에 수백 테라바이트를 GPU가 바로 참고해야 하는 시대가 열립니다. 그때 HBF가 성능의 상한선을 결정짓게 되는 것입니다.

기술적 도전과 전망

HBF 적용에는 여러 난관도 있습니다. 용량과 속도만큼 전력 소모와 열 관리, 그리고 낸드 플래시의 적층 한계(요즘은 256~512층까지 올라가기도 함)를 고려해야 하고, GPU와의 직접적인 ‘버스 연결(IDD, PCIe, InfiniBand 등)’도 기술적으로 맞춰야 합니다.

하지만 이미 데이터센터 설계가 메모리 중심으로 재편되고 있는 지금, 과거 CPU에서 GPU로의 권력이 이동했던 것처럼, 앞으로는 ‘메모리 크기와 구조’가 AI 서비스의 성패와 투자 수익까지 결정하는 요소가 될 것임이 분명합니다.